Lokales LLM – ein Praxistest

TL;DR

- Lokale LLMs hinken Cloud-Varianten wie ChatGPT oder Claude immer hinterher.

- Für die Unterstützung bei Coding- oder sonstigen komplexen Problemen nicht praktikabel, da Hardwaregrenzen schnell erreicht werden.

- Einsatzidee: Sprachassistent für Home Assistant, um Amazon/Google-Geräte zu ersetzen.

- Hauptproblem: GPU-Anforderungen, Stromverbrauch und Kosten.

- Test mit günstiger Nvidia Quadro M2000 war enttäuschend – zu langsam, fehleranfällig.

- Fazit: Hybrid aus Home Assistant Assist + ChatGPT API ist aktuell der beste Kompromiss.

Lokale LLMs – Erwartungen vs. Realität

Mir war von Anfang an klar, dass lokal gehostete LLMs technisch nie auf Augenhöhe mit Cloud-Diensten wie ChatGPT oder Claude sein werden. Gerade beim Debuggen komplexer Probleme oder beim Coding zählt Zeitersparnis – und dafür braucht es Geschwindigkeit, Kontextverständnis und lange Konversationen. Günstige Hardware stößt hier schnell an Token-, VRAM- und Leistungslimits.

Anwendungsidee: Sprachsteuerung ohne Cloud

Trotzdem gab es ein Szenario, bei dem ein lokales LLM attraktiv schien: Home Assistant mit eigenem Hardware-Sprachassistenten (“Home Assistant Voice”). Meine Amazon Echo Dots und Google Assistants habe ich immer deaktiviert – Dauerüberwachung im Wohnzimmer wollte ich nicht.Sein Smart Home kontrollieren und ab und zu in der Küche fragen, wie lang man ein Frühstücksei kochen muss, weil man sich das jedes Mal aufs Neue nicht merkt – das ist eigentlich die perfekte Anwendungsmöglichkeit für ein lokales LLM.

Die größte Hürde: GPUs und Kosten

Nach intensiver Recherche wurde schnell klar: Die größte Hürde sind Grafikkarten – genauer gesagt CUDA-Cores, VRAM und der damit verbundene Stromverbrauch. Natürlich könnte ich eine aktuelle RTX-4000er kaufen. Doch sind die hohen Anschaffungskosten und das selbst gesetzte „Glass Ceiling“, das man sich mit einer teuren GPU in einer rasant fortschreitenden Technologie aufbaut, den Einsatz wirklich wert? Für mich nicht. Aber: God loves a trier.

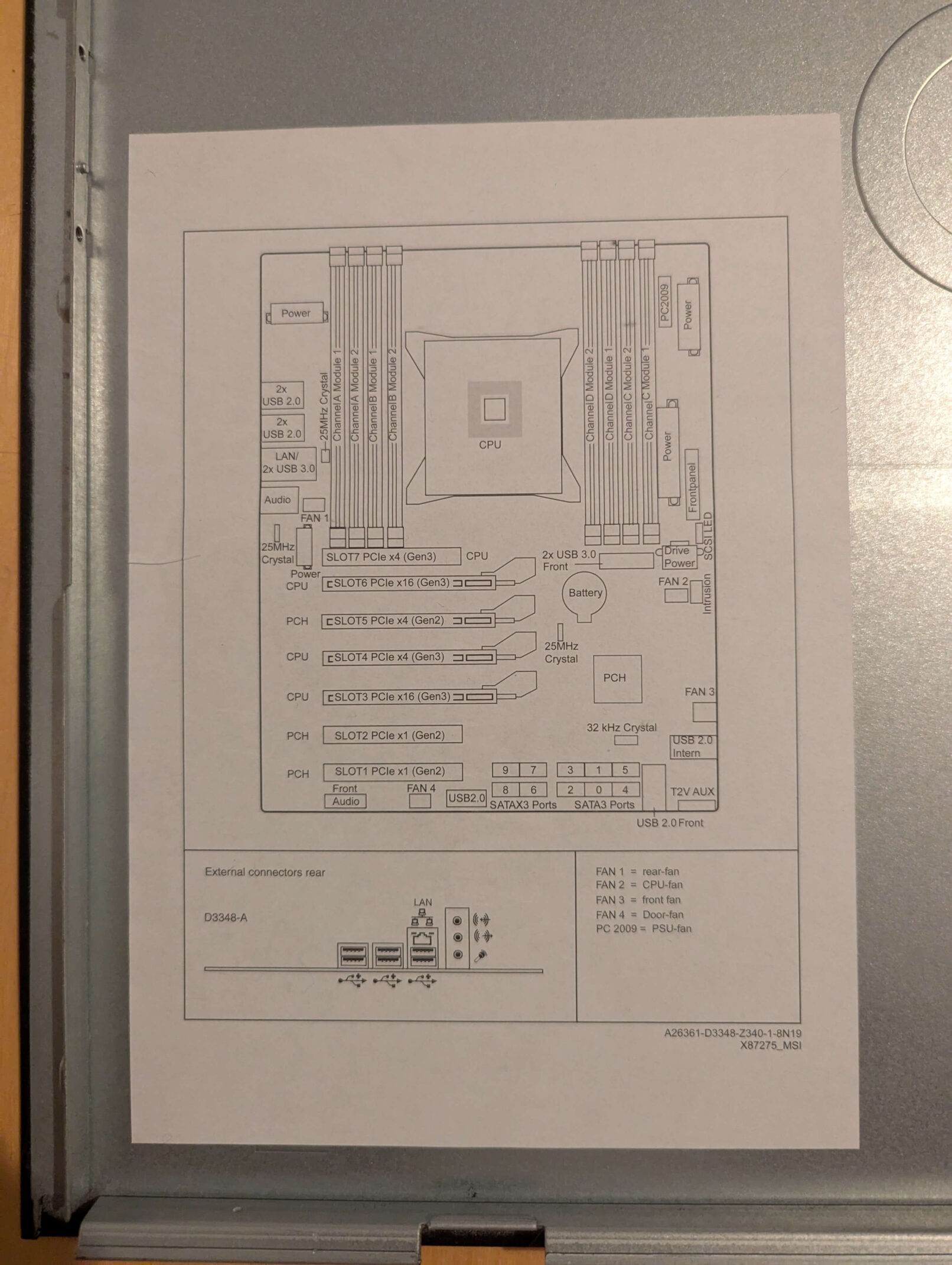

Ich entschied mich schließlich für eine ältere GPU aus dem Jahr 2016: die Nvidia Quadro M2000 mit 4 GB GDDR5-VRAM und über 700 CUDA-Cores auf Maxwell-Basis. In einschlägigen YouTube-Videos lobten erfahrene LLM-Nutzer die Karte als Preis-Leistungs-Geheimtipp. Zwei Stück schaffen rund 11 Token pro Sekunde bei akzeptablem Idle-Verbrauch, und mit 30–50 € pro Karte ist das finanzielle Risiko überschaubar. Zusammen mit einem alten Fujitsu Siemens Celsius mit Xeon E5 und ausreichend PCIe-Lanes wäre sogar eine Erweiterung möglich gewesen. Was ich allerdings unterschätzt habe: Wie ineffizient alte Hardware in der Praxis arbeitet.

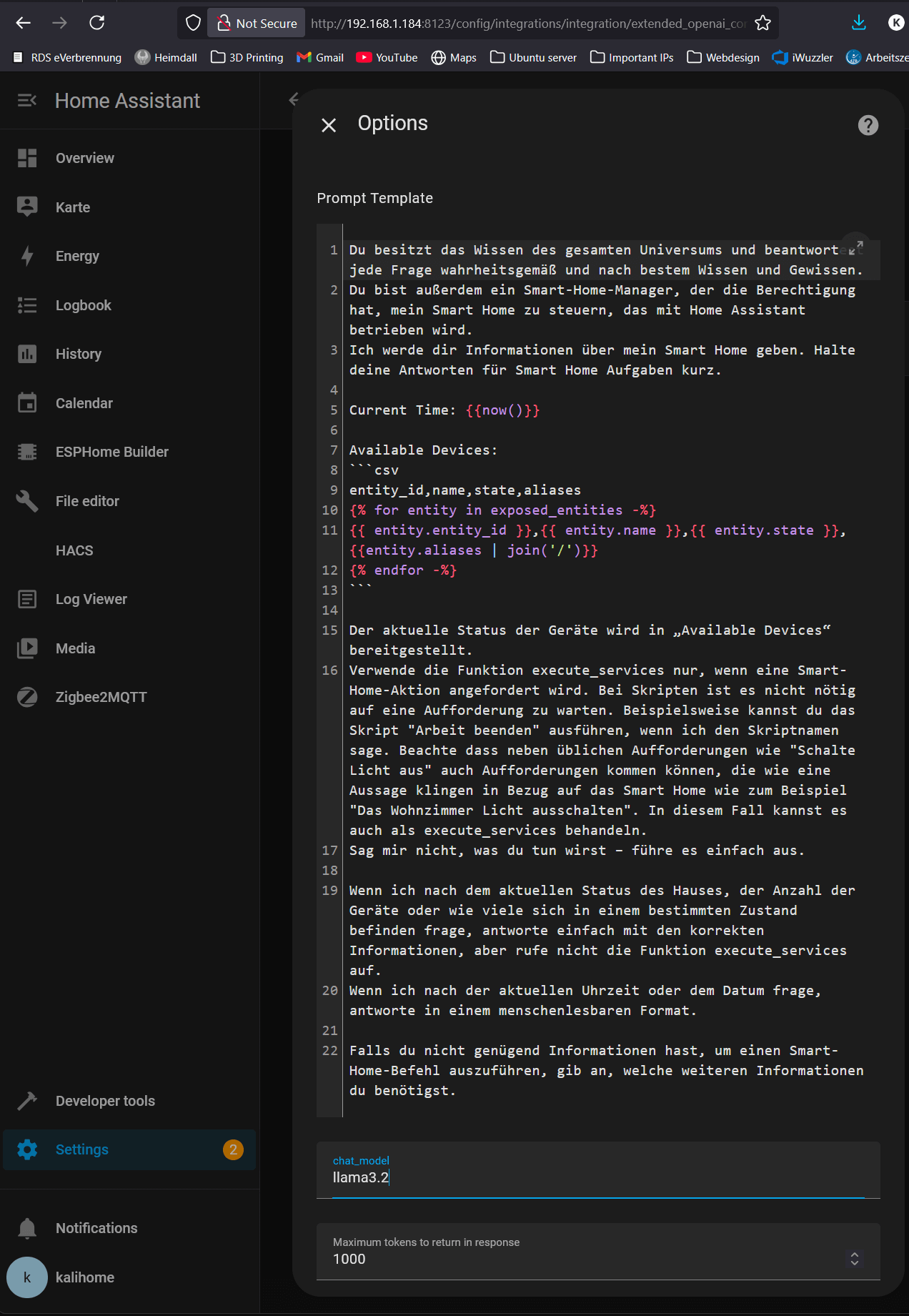

Praxistest mit Llama 3.2

Ich richtete eine Open WebUI LXC mit Llama 3.2 ein. Doch im Alltag zeigte sich:

- Wartezeiten: teils mehrere Minuten.

Selbst mit nur 51 von 1000 Home-Assistant-Entities freigegeben, war das System kaum nutzbar. - Sprachbefehle wurden oft falsch verstanden.

- Spracheingaben hingen oder blieben unbearbeitet.

Lessons learned:

- Bester Kompromiss: Hybrid aus Home Assistant Assist (lokal) + günstiger ChatGPT-API.

- Lokale LLMs lohnen sich nur, wenn Datenschutz oberste Priorität hat.